一點靈犀/中美AI競爭是一場長跑拉力賽\李靈修

「DeepSeek風暴」持續震撼資本市場,帶動科技板塊股價表現驚艷。但我們也要清醒認識到,LLM(大語言模型)只是本輪AI革命的初步階段,中國企業若想留在舞台中央,仍須在技術研發與人才儲備方面持續投入。

DeepSeek最為人稱道的地方,就是以落後的GPU芯片條件,追趕上了先進的閉源大模型性能。但這也從一個側面反映出,LLM的發展進度正在遭遇瓶頸,即「ScalingLaw撞墻效應」。所謂ScalingLaw是指,在參數規模、訓練數據集或用於訓練的計算量增加時,LLM的性能會按照某種「冪律關係」提升。這也被看作是AI領域的摩爾定律。

產品迭代出現停滯

但現實情況是,外界最早預期2023年底就會推出的GPT-5,時至今日仍然「難產」,OpenAI也因此被嘲笑為「史上最偉大的期貨公司」。據業內人士透露,OpenAI着手組建了10萬卡集群,但模型訓練效果未如理想,這也造成了產品迭代的停滯。也就是說,被DeepSeek追上身位的主因是,OpenAI自己跑得越來越慢了。

如果再深挖下去,LLM本身就存在明顯的天花板,未來可能會被新的AI技術所替代。筆者去年3月2日撰文《Sora會讓我們丟掉工作嗎?》指出,LLM依靠高質量的數據標註與訓練,強行「記住」了一定的文本規律,懂得根據上文來生成下文,但並非真的掌握了自然語言。

在AI學術圈也曾有過「中文房間」的假設,這是1980年美國科學家約翰·瑟爾提出的思想實驗,如果一個只懂英語的人被關在屋裏,手裏拿着一本中英文詞典,指導其根據接收到的中文信息選擇合適的中文字符來做回答。從屋外的視角來看,這人好像懂中文,但其實一竅不通。

人才儲備至關重要

LLM的局限性也正在於此,只能處理信息之間的相關性,而無法掌握物理的因果律,這極大地降低了大模型的可靠性及穩定性。更重要的是,由於計算機運算及存儲的物理特性,現有的大模型只能處理離散型號(如自然語言),但無法應對視像及聲音等連續信號。

這也就解釋了,為什麼LLM在聊天方面表現出色,但無法對物理世界進行建模,更不能像人類一樣進行複雜的邏輯思考。根據Meta首席科學家楊立昆(Yann Le Cun)的說法,一個4歲孩子僅憑藉視覺接收到的信息量,就已是目前最大規模LLM模型訓練量的50倍以上。

目前AI領域的頂尖科學家,都在為下一階段的技術突破在做積累。如「AI教母」李飛飛提出的空間智能,就是讓AI能從處理二維信息為主轉向三維空間信息處理,進一步提升智能水平和適應能力。

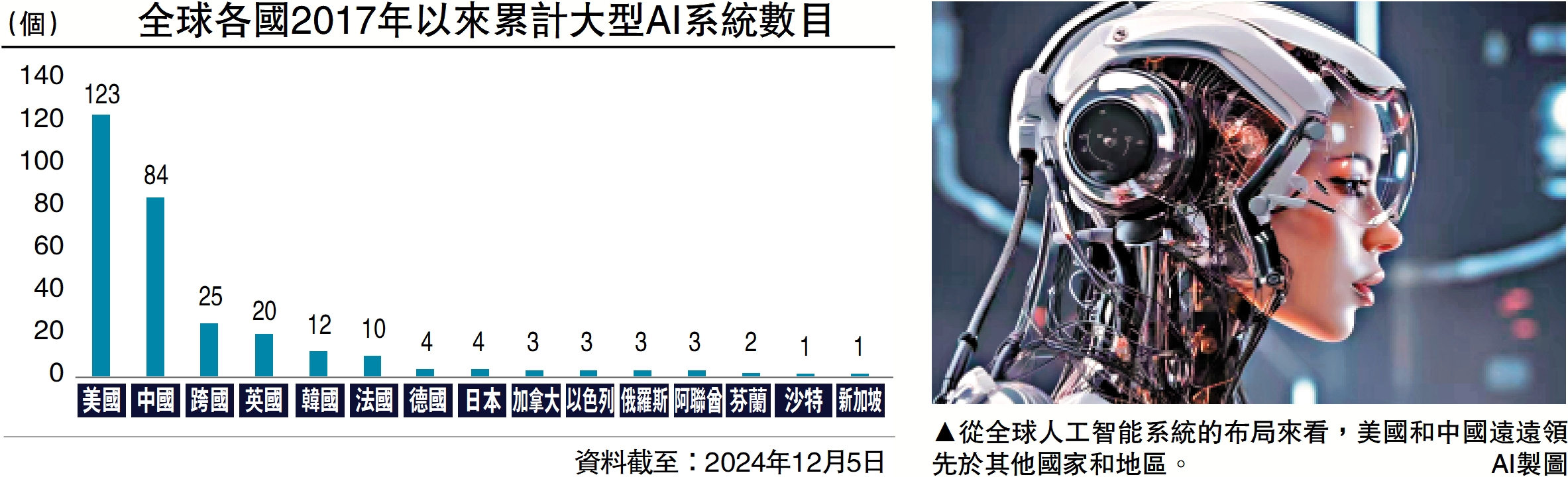

而從全球人工智能系統的布局來看,美國和中國遠遠領先於其他國家和地區,可以說行業呈現的是「雙頭格局」。(見配圖)展望未來,如果中國想要繼續緊跟技術前沿,人才的持續培養將成為重中之重。

去年麥克羅波洛智庫(MacroPolo)公布了一項名為「全球人工智能人才追蹤」的調查。數據顯示,65%的頂級AI人才出自中美兩國。在頂級(前20%)AI研究人員的原籍國中,中國有47%,遠超美國(18%)。但在研究生階段,大量人才流向美國,使得在最頂級(前2%)AI研究人員的就業國家中,中國位居第二(12%),落後於美國(57%)。