一點靈犀/Sora會讓我們丟掉工作嗎?\李靈修

春節期間,文生視頻AI工具Sora橫空出世,贏得一片讚美之聲,更被業界推崇為「世界模擬器」(World Simulator),即可準確展現真實物質的運動規律。但今次筆者撰文「斗膽」預測,文生視頻AI距離商用水準仍有不小差距。而在現有GPT技術框架下,本輪AI熱潮在經歷數年的快速迭代後將遭遇發展瓶頸。

必須要承認,Sora相較文生視頻的AI前輩們──Runway、Pika,不僅在時長上實現了突破(Sora長達1分鐘,Runway基礎視頻為4秒、Pika為3秒),並在視頻流暢度、光影處理等方面均取得大幅進步。

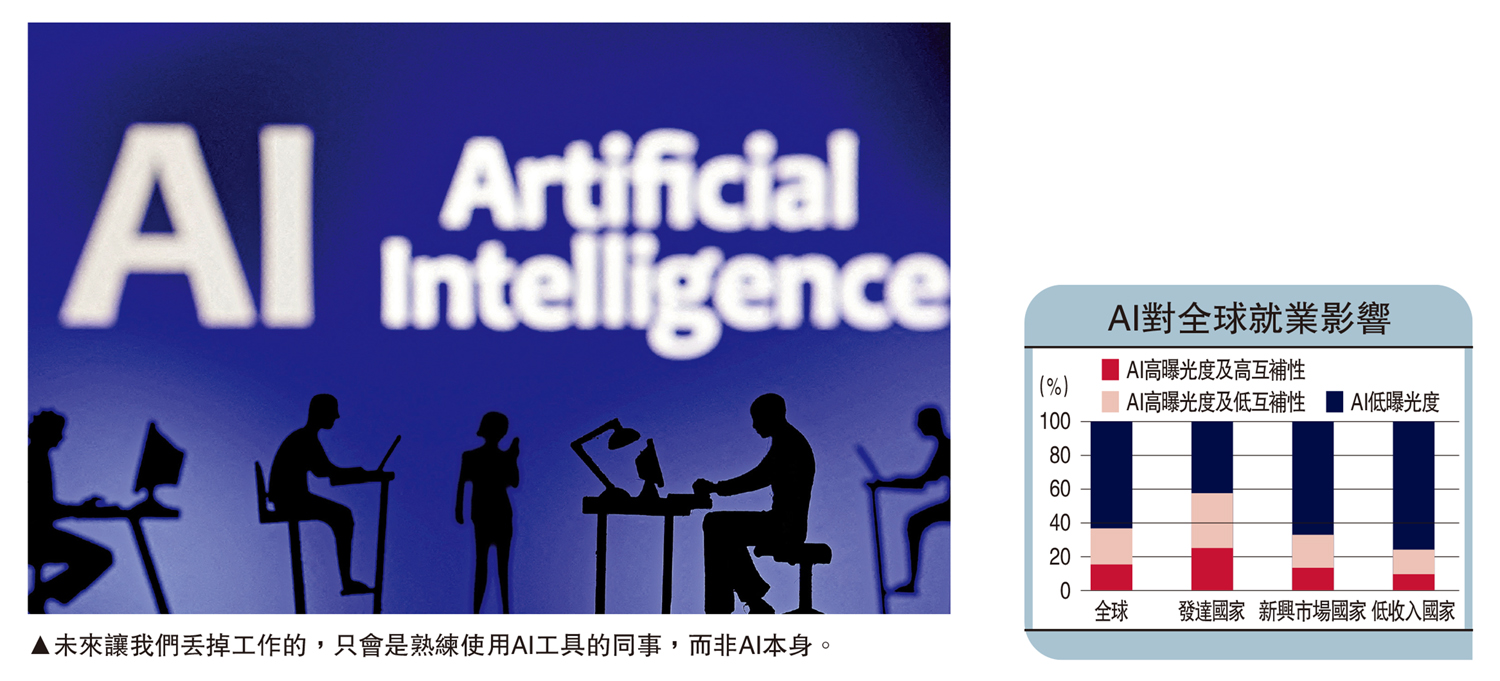

這也是為什麼,每次AI工具迭代都會引發一波「失業恐慌」。就在年初,IMF(國際貨幣基金組織)還發布報告指出,全球近40%的就業崗位會受到人工智能的影響。

圖靈測試與中文房間

不過,筆者要為Sora潑冷水。現行AI技術的底層理論─人工神經網絡(Artificial Neural Network),只是通過二進制方式模仿大腦神經的決策流程。也就是說,包括Sora在內的所有AI工具,貌似理解物質世界,但僅是「濫竽充數」。

早在1950年,英國科學家艾倫·圖靈就提出一個標準,用來評判機器是否達到人工智能的水平。機器A被關在房間中,與屋外的人類B通過文字交流。如果人類B無法分辨房間內是人類還是機器,則機器A通過了「圖靈測試」。

但到了1980年,美國科學家約翰·瑟爾提出了質疑。他描述了這樣一種情況:如果一個只懂英語的人被關在屋裏,手裏拿着一本中英文詞典,指導其根據接收到的中文信息選擇合適的中文字符來做回答。從屋外的視角來看,這人好像會懂中文,但其實他一竅不通。

局部合理與整體荒謬

那麼,如果給機器A一本《物質世界指南》,屋外的人類B很容易產生錯判─房間裏的機器A好像真的擁有了人工智能。事實上,GPT模型的性質仍屬機器智能,依賴於高質量的數據標註與訓練。GPT只是記住了如何根據上文來生成下文,並非真的掌握了自然語言。

正是由於「中文房間」效應,我們在使用ChatGPT時,經常遭遇AI出現「幻覺」:捏造內容或者答非所問。這種偏差在文生視頻工具中又被放大了,特別是Sora將視頻輸出延長至1分鐘,給了AI更多「犯錯」機會。

當我們認真觀看Sora的演示視頻時會發現,如果只是聚焦單一物體,呈現出的運動效果非常優秀,但如果兩個物體之間產生接觸,Sora就無法準確模擬出真實的物理規律,如吹滅蠟燭。

這是因為GPT模型只能處理信息的相關性,而無法掌握物理的因果律。受此影響,Sora生成的AI視頻「局部合理、整體荒謬」,極大地降低了自身的可靠性及穩定性。這一問題是由技術缺陷所致,靠算力和數據無法從根本上彌補。也因此,未來讓我們丟掉工作的,只會是熟練使用AI工具的同事,而非AI本身。

至於外界憧憬的「世界模擬器」,只能等到腦科學實現重大突破的那一天了。